Hello! 各位 AI 開發者大家好 👋

我是 ihower,這次過年好忙,又是 DeepSeek R1 又是 OpenAI o3-mini,真是春捲啊 🌯🌯🌯

🔝 AI 大神免費深入淺出全面講解大型語言模型、訓練、心理學到實際應用

大神 Andrej Karpathy (前 OpenAI 共同創辦人、特斯拉人工智慧總監) 寫的這個 LLM 模型訓練的比喻(出處 tweet)太讚了,這裡翻譯分享給大家:

讓大型語言模型 (LLMs) 去上學:

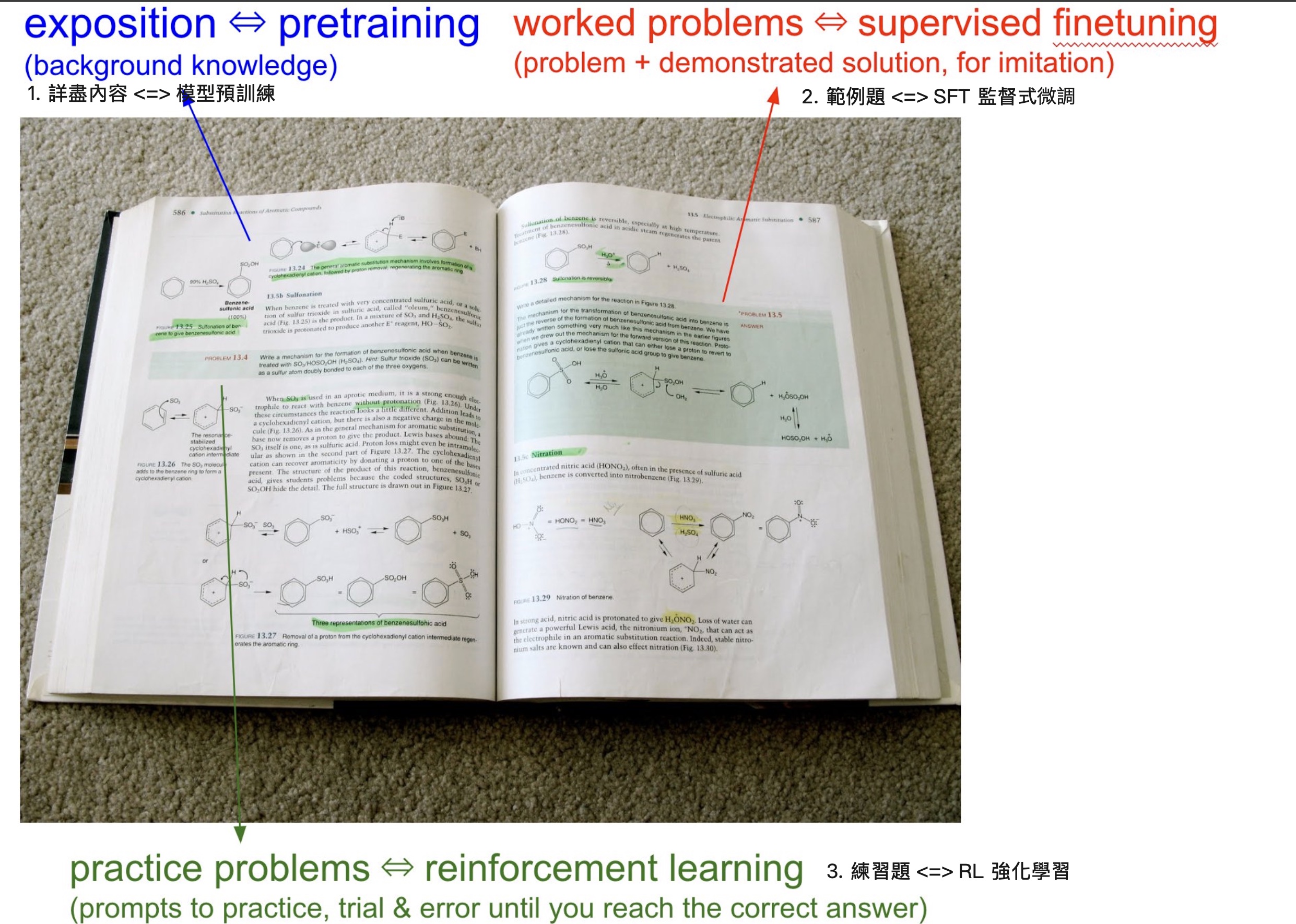

當你打開任何一本教科書時,你會看到三種類型的主要內容:

- 背景資訊/解說: 這部分是教科書的主要內容,用來解釋各種概念。當你專注閱讀時,大腦正在把這些內容進行學習與訓練。這就相當於「預訓練」(pretraining),模型透過閱讀網路資料,累積背景知識。

- 有解答過程的範例題: 這些是專家如何解題的具體案例,示範給學生來模仿學習。對模型來說,這就相當於「監督式微調」(supervised finetuning,縮寫是 SFT),也就是讓模型根據人類撰寫的「理想回覆」來做微調,來提升作為 AI 助理的表現。

- 練習題: 這些是給學生的練習題目,通常不會提供解題過程,但都會附上最終答案。每章最後通常會有大量這種題目,目的在於讓學生透過反覆嘗試來學習 – 學生必須嘗試各種方法才能得到正確答案。對模型而言,這相當於「強化學習」(reinforcement learning,縮寫是 RL)

目前我們已經讓模型接受大量的第 1 類(背景知識) 和第 2 類(範例學習)訓練,但第 3 類(練習與試誤學習) 仍然是個新興逐漸開展的新領域。

當我們為模型建立訓練資料集時,本質上與撰寫教科書並無不同,需要同時包含這三種類型的資料。它們必須先閱讀,然後再做大量練習。

大神還接著錄了三個多小時的教學影片,免費深入淺出全面講解大型語言模型、訓練、心理學到實際應用!

這裡感恩 Fox 大大翻譯繁體中文字幕。

🧠 DeepSeek FAQ

近期 DeepSeek 引起了很大的話題,這份 Ben Thompson 整理的 DeepSeek FAQ 非常不錯。

這有繁體中文翻譯版本

布丁大大也展開了基於 R1 的「台灣製造」大型語言模型計劃,歡迎支持。

👍 Reasoning Model 是如何練成的?

Sebastian Raschka 是 Build a Large Language Model (from Scratch) 一書的作者,繁體中文翻譯版天瓏書店有售。

這篇非常棒的文章探討了四種不同策略來建立推理模型,特別是對於 DeepSeek R1 是如何訓練成推理模型,是我看到最棒的講解。

不過呢,對於文章中猜測的 OpenAI o1 做法,我個人有看到 RL 專家 Nathan Lambert 持有不同看法,詳見 OpenAI’s o1 using “search” was a PSYOP 和 the State of Reasoning。

📚 DeepSeek R1 和 o3-mini 發布考試成績

OpenAI o3-mini 趕在當初 Sam Altman 說好的一月底的最後一天發布了,兩個我比較關注的 benchmark 考試成績也出爐了:

- LiveBench: o3-mini high 排第一,並且 coding 這項的分數超高 🤩

- Humanity’s Last Exam (HLE) 人類的最後考試: o3-mini 奪回第一名了,不過仍只有 13% 答對率

LiveBench 每月都會更新問題集(來自最新的資料,例如新聞、論文、電影等),因此各家模型在訓練時是無法先背起來的。區分 6 種類別並將隨著時間的推移發布更新更難的任務。

HLE 則是上個月 Scale AI 發布的最新 AI benchmark,考的是人類專家級知識領域(偏學術)的極限表現。有 3000 題文字和多模態(圖像)的原創可驗證題目,聚焦在知識和推理能力,並且有公開跟非公開的 dataset 以避免模型事先背書。

不過注意到 OpenAI o3-mini 跟 DeepSeek R1 都不是多模態模型,因此 HLE 只能考其中的純文字問題。我在 paper 附錄中有找到其他模型也只考純文字的分數,排名是一樣順序。

更多討論在我 Facebook 貼文。

📊 強化學習(RL)很神奇,直到它沒那麼神: 探討推理模型的困境

最近因為 DeepSeek R1 的關係,蠻多人在講這是 LLM 的 AlphaGo 時刻,使用強化學習(Reinforcement learning) 讓 AI 可以自我升級超越人類。

的確,最新的推理模型 (OpenAI o1, o3, DeepSeek R1 等) 在推理、數學和程式設計等理組問題上表現有所突破,但是文組寫作能力似乎就沒什麼提升啊?

說起來 RL 也不是新的理論,這不禁讓我懷疑起來,用 RL 在 LLM 上真的可以這麼幸福嗎? 趁連假消化了一堆書籤中,撈到去年底 The Problem with Reasoners 這篇文章覺得很讚。作者 Aidan McLaughlin 今年起在 OpenAI 任職做 Model Design,這篇文章撰寫於去年11月(當時已有 o1-preview 和 DeepSeek-R1-Lite-Preview)

全文翻譯在此,以下是一些重點摘要:

- RL 的魔力在於: 你只要建立一個環境,設定一個目標獎勵函數,就可以看著一個可愛的小代理人一路衝到超越人類技能

- 推理模型(Reasoning model)本質上是用強化學習(RL)訓練出來的模型

- 是基於 GPT-4 等基礎模型,使用大量”可以驗證”答案的問題,搭配合成的 CoT 推理步驟來做 RL (註,這個流程可以參考 DeepSeek R1 paper 有公開的配方)

- 特別適合有清晰回饋的領域(如數學、程式設計)

泛化能力有侷限:

- 但是難以泛化到訓練領域以外,在寫作等領域表現反而不如 gpt-4o

- 在情緒理解能力上,甚至僅與較小的模型相當

- 若你無法蒐集到幾乎無盡的練習題和判定機制,就沒法充分利用它的推理性能

長時間推理的能力有限制:

- 目前觀察到的 o1-mini/preview 最長的思考也就 1 萬多個 tokens (相當於人類花幾個小時寫的內容)。這聽起來很厲害,但若目標是打造「超級智慧」,我們需要的是相當於「人類思考幾百年」的推理

- 如果要訓練規模更大的 RL 才能讓模型推理更長,那就失去「調整推理計算量 (inference compute)」的意義

- 因為調整推理計算量的目標之一是:若想要對問題分析更徹底得到更好的答案,可以直接把 AI 的推理時間拉長,不需要等下一代模型問世。這可以說是「預支未來」。然而若要解鎖更多推理深度,卻得等更強的 RL 訓練來完成,那你就又得等待更強的模型推出….

- 而且擴大 RL 規模在一個固定大小的模型上往往會犧牲其他能力,要讓 o3 思考一百萬個 tokens,或許得付出「除了數學其它都不會」的代價

更大的產業啟示:

- 大型模型的預訓練擴展遇到瓶頸,現況不容樂觀,現在大家都轉而鑽研如何複製 o1,使用 RL 提升推理能力

- 假如你不是數學家或 Leetcode 神人,你應該更關心那些「無法輕易驗證」的領域。若我們只建造更強的 reasoners,而不增大模型規模,AI 在以下這些領域可能就永遠停留在 GPT-4 的水準:

- 給企業做策略建議

- 安撫心靈受傷的朋友

- 給政府提供建議

- 寫出一篇轟動的哲學論文

- 新創投資判斷

- 管理一個團隊

- 創作令人驚嘆的詩歌

- 職涯諮詢

- 理解社會趨勢

- 評論文章、給出寫作回饋

以上,蠻引人深思的文章,全文寫得很好,推薦一讀。

更多討論在我 Facebook 貼文。

🌟 YC 的 DeepSeek R1 解析

由 MediaTek Research 首席研究員 YC 寫了兩篇 DeepSeek 的研究分享:

- DeepSeek R1解析 — LLMs可以從訓練中自己學出推論能力!!

- DeepSeek V3 降本篇

- DeepSeek 增效篇: 敲碗中

當然,別忘了關注 MediaTek Research 最新適合正體中文使用者的 Breeze2 模型。

🎯 文本推理和音頻推理之間存在顯著的性能差距

之前分享過幾次 OpenAI Realtime API 的進展,這種 speech-to-speech 的模型因為省去了額外的語音辨識和合成步驟,可以達到很低延遲的對話,也可以做到情感、重音、不同口音,非常厲害。

不過最近看到 Artificial Analysis 發了一個評測 Big Bench Audio 專門用來評估 “語音模型” 的推理能力,然後發現用語音會變笨! 😅

同樣的 benchmark 題目,實驗比較了四種方式: Speech-to-Speech、Speech-to-Text、Text-to-Speech、Text-to-Text。

用 text-to-text 當然是最聰明的,用 speech-to-speech 則變笨最多,具體看看分數:

- gpt-4o 用 text-to-text 是 92% 準確率 (也就是傳統 pipeline 方式: 用 whisper 語音辨識成文字 + gpt-4o 模型 + TTS 語音合成)

- gemini-2.0 Flash 是 81%

- gpt-4o 用 text-to-speech 是 74% (同一個模型文字輸入、語音輸出)

- gemini 2.0 Flash 用 speech-to-text 是 67% (同一個模型語音輸入、文字輸出)

- 最後是 gpt-4o 用 speech-to-speech 只得 66%

看來用 speech-to-speech 模型目前不宜做太困難的任務。

更多討論在我 Facebook 貼文。

🛠️ Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

讀了去年 2024/8 月 Google Deepmind 的這篇論文: Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

應該是最早說出 Test-Time Compute 也是一種 Scaling 範式的開山之作。

論文中探討了在推理階段適當增加計算資源(Test-Time Compute),可能比單純增加模型參數更有效。實驗中做出的最佳化,性能超越參數量大14倍的模型。

現在唸書可以搭配 OpenAI Deep Research 一起讀: 丟 paper 並要求找出所有相關的 papers 幫忙分析整理論點:

- 雖然可以顯著提升其問題解決能力。但提升效果並非無限持續,會在一定範圍後會趨於飽和

- 提升是有前提的,不是萬能的:模型必須對該問題有一定的知識儲備、推理能力和解題勝算

- 如果一個問題完全超出模型知識或能力範圍,即使投入更多推理計算,模型也可能無法找到正確答案

- 在適當範圍內增加推理計算(例如多步推理、反覆自我修正、生成多個答案再篩選)大多能提升LLM的解題能力,只是提升幅度會隨著計算量而逐漸趨緩

- LLM 解題表現隨 Test-Time Compute 增加而提升的關係並非線性,而是呈現邊際效益遞減的趨勢,類似對數或次線性的關係

- 最初增加計算量時,性能常有大幅提升,但隨著計算量進一步增加,增益逐漸縮小。存在性能 “飽和點”

- 也就是 問題難度 和 模型基礎能力 為提升效果設定了 “天花板”

總之,訓練階段和推理階段的擴展各有用武之地,目前最先進的做法是 將兩者結合:一方面通過更多數據和強化學習讓模型具備更強的推理技能,另一方面在推理時讓模型充分利用時間進行思考和搜索

另外要注意,這篇 paper 的推理策略是:

- Self-Consistency: 需要針對同一個 query 讓 LLM 多次回答,然後投票選最佳答案。

- Iterative Refinement: 讓 LLM 自我檢查 & 修正,通常需要數輪迭代。

- Tree-of-Thought & Beam Search: 讓 LLM 同時探索多條推理路徑,然後選擇最佳答案。

這些方法都需要「多次平行或迭代呼叫 LLM」,對比目前最強開源推理模型 DeepSeek R1 則是在單次 Chain-of-Thought 就能夠產生很長的厲害推理過程。

R1 能夠在單次 CoT 就這麼厲害,當然是因為訓練階段就有特別練過(用強化學習) CoT 的推理能力。沒特別練過的模型做 CoT 雖然也可以逐步思考,但如果想錯了容易因為自身的謬誤導致最終答案錯誤。要有練過的模型才能夠在單次 CoT 輸出做到探索循環驗證回溯修正的推理。

至於 OpenAI 的 o1 和 o3 是哪一種,是透過推論階段才做搜尋(這種推論成本較高),還是像 R1 那樣單次 CoT 達成(推論成本較低), 由於實作細節未公開,仍存在很多討論爭議(猜吧)。

更多討論在我 Facebook 貼文。

📚 湧現 Emergent 很可能只是假象

原來語言大模型所謂的神秘 “湧現 Emergent” 現象,只是 benchmark 實驗設計問題所導致的假象,而非真正的斷層式能力產生。

整理教材時看到 2023 年 4 月 Stanford 的一篇論文 Are Emergent Abilities of Large Language Models a Mirage?

2023 年算是舊聞不是什麼新知了,但我覺得還是蠻有啟發的。

- 所謂的「湧現」,很可能只是一種「評估方式或度量指標」以及「模型規模取樣不夠密集」所造成的假象,而不是真正的能力跳躍

- 因為採用 不連續、門檻式 的評估指標(例如答對題目的百分比,一旦錯一題就算失敗),就容易導致「忽然大幅躍升」的觀感

- 如果使用 漸進連續 的評估方法(例如答對部分關鍵字或逐個字母給分的評量模式),加上觀察模型在多個參數模型規模點上的表現,就會看到該任務上的表現其實一直在平滑地提升,並沒有真正的「閾值跳躍」

因此只要改變評分方法,就能將「斷層式曲線」變回「穩定平滑曲線」,湧現現象不一定是大模型產生了質變能力,而只是評量方式使得分數看起來突然跳耀而已。

更多討論在我 Facebook 貼文。

🔍 OpenAI Deep Research 非官方指南

OpenAI 最新發布的 Deep Research 功能讓我非常驚艷,要能輸出如此長篇言之有物的內容很不容易。

相比 gpt-4o 的搜尋功能是單次搜尋後,模型回答就結束了。這個新的 Deep Research 是個 Agent 系統,是個查一查思考下一步後再查一查的迴圈過程,最後都研究好了才給報告,整個研究過程可以長達 20 分鐘。

不過目前只開放 Pro 用戶使用(的確有點貴),但是 Sam Altman 有考慮 Plus 用戶即將也可以一個月用 10 次。

這篇 OpenAI Deep Research Guide 是由 Elvis Saravia 博士整理的 OpenAI Deep Research (非官方)指南,內容還不錯,包括以下內容:

- Q: 什麼是 Deep Research?

- Q: 它解決了什麼問題?

- Q: 有哪些使用情境?

- Q: Deep Research 與其他解決方案有何不同?

- Q: OpenAI 的 Deep Research 使用技巧

- Q: 可以嘗試哪些應用?

- Q: 缺少了什麼 / 挑戰是什麼?

全文翻譯在此,我在最下方還加上了我的額外內容,包括我自己的 Deep Research 分享、關於 ChatGPT deep research 的 system prompt、和 Gemini Deep Research 的比較等。

最後推薦一個課程: Gen AI 年會與小聚的主辦人 Muyueh Lee 李慕約 的 365 AI 訂閱計劃 已經開賣啦!

對職場工作人來說,直接一整年不用煩惱追什麼 AI 工具新知,跟著李慕約陪跑學習就好啦 👍😘

更多詳細的內容在課程網頁上寫的非常完整: pse.is/6yw436

我的 $240 專屬折扣碼:IHOWER

– ihower