(整理分享一些關於 Spec-Driven Development (SDD) 的看法和內容)

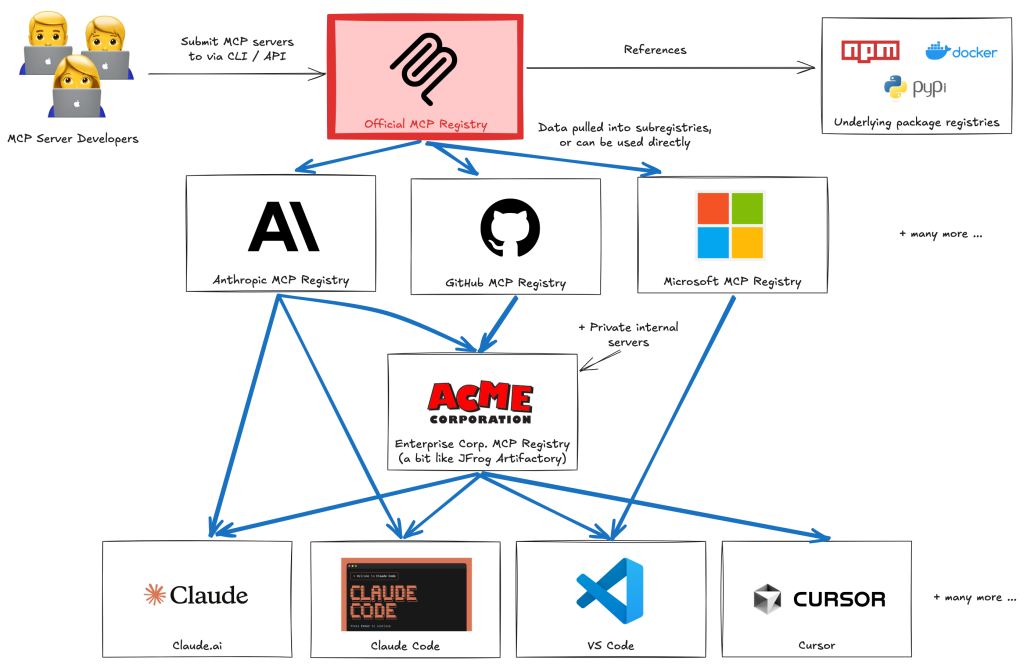

Spec-Driven Development (SDD) 是什麼? 簡單說講就是在用 AI 寫程式之前,先讓 LLM 生成一大堆規格文件: 產品需求 → 技術設計 → 任務清單,然後才交給 coding agent 執行。目前有幾個工具在推這套流程: GitHub 的 Spec-Kit、AWS 的 Kiro、還有 Tessl。

社群討論其實非常兩極。正面看法認為遠比 vibe coding 可靠、適合要上線維護的真實專案、開發速度中期來看其實更快。負面看法則認為這就是 Waterfall 2.0、過度工程化、扼殺創造力。

閱讀全文〈Spec-Driven Development(SDD) 的美好願景與殘酷現實〉