Anthropic 最近才釋出了他們在 2025/5/22 開發者大會的完整影片,當時的重頭戲是 Claude 4 模型發布。其中有兩場關於 prompting 教學的演講內容很不錯,這兩場演講從基礎 Prompt 到針對的 Agent 的 prompting ,展現了 prompt engineering 的不同層次,推薦大家一看。以下是我的解讀整理。

第一場: Prompting 101

😆 👨🏻💻 ✨ 🚀 💰

Anthropic 最近才釋出了他們在 2025/5/22 開發者大會的完整影片,當時的重頭戲是 Claude 4 模型發布。其中有兩場關於 prompting 教學的演講內容很不錯,這兩場演講從基礎 Prompt 到針對的 Agent 的 prompting ,展現了 prompt engineering 的不同層次,推薦大家一看。以下是我的解讀整理。

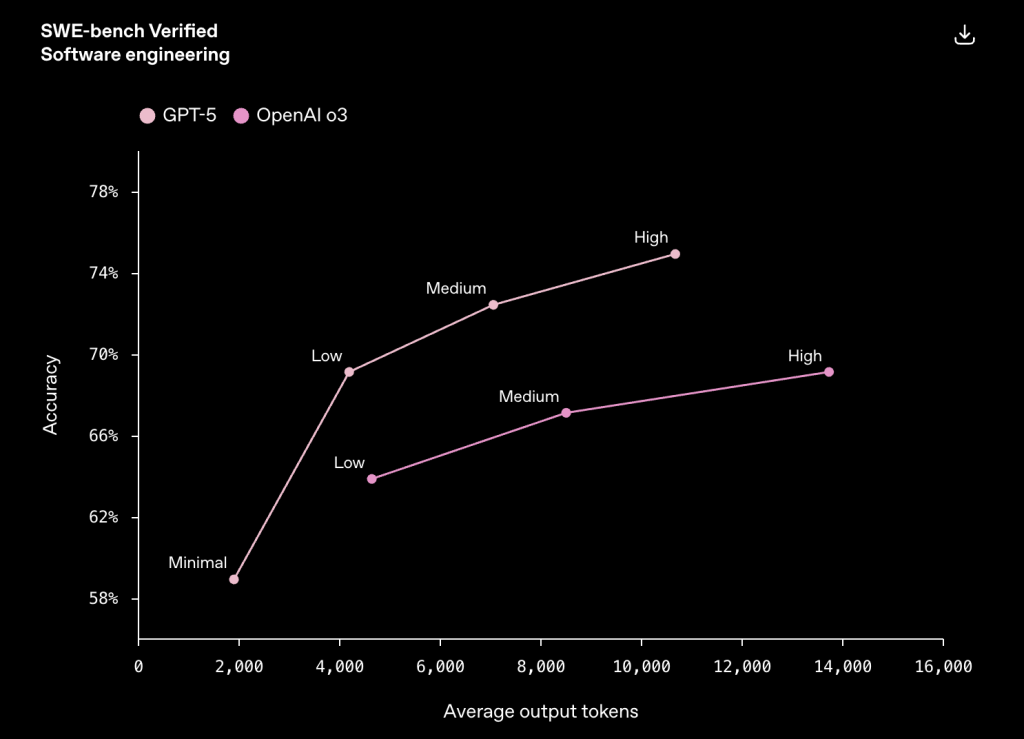

OpenAI 於 2025/8/7 推出 GPT-5,包括 ChatGPT 和 API 都同時上線,這裡針對 AI 開發者快速解惑與整理重點。

首先,ChatGPT App 的模型與 API 平台上的模型,並非一一對應,這點常讓開發者搞混。讓我說清楚。在 ChatGPT App 裡,其實是一個系統,包含:

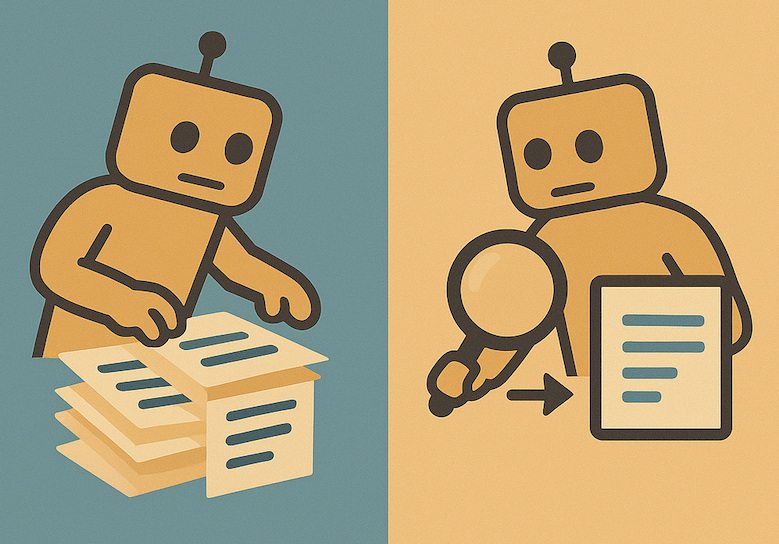

看了一場 Augment Code (也是一家做 AI IDE 的廠商) 來講 “Agentic 檢索” 對比 “傳統 RAG 檢索” 的演講,蠻有啟發的。

在 AI Coding 領域,簡單的工具正在擊敗複雜的 RAG 系統。

AI Coding 的演進是這樣:

隨著每次演進,IDE 底層檢索的複雜度越來越高。我們知道 LLM 需要正確的 context 才能良好運作(也就是 context engineering),因為需要設計一套檢索系統,找出當下模型所需要參考的程式碼。

像 code completion 只需要超低延遲的簡單檢索即可,chatbot 時代需要理解更複雜的抽象問題,而 agent 就必須理解整個專案的許多不同部分。

他們對 AI Coding 領域的驚人發現是: 簡單的工具就夠了,Augment 團隊在 SWE-Bench 拿下第一名,論文中寫道:「我們探索了新增各種基於嵌入的檢索工具,但發現對於 SWE-Bench 任務來說,這並不是瓶頸。用 grep 和 find 工具就足夠了」。

近期很夯的 Claude Code、OpenAI Codex、Gemini CLI 也通通沒有用 embedding 模型來做檢索。

程式碼檢索為什麼 grep/find 就夠用? 因為程式碼有很多高訊號的關鍵字詞彙,這些結構化的關鍵字讓 grep 搜尋變得非常有效。

最近看了幾篇討論 AI 產品經理和 AI 專案管理的內容,最有感的是這句話:「傳統軟體開發是確定性的,但 AI 開發本質上是應用研究」,這根本性的差異改變了一切。

傳統 PM 會說「我們 9/21 要發布這個 AI 功能」,但問題是:你怎麼為還沒被發現的東西制定 Roadmap?這就像在地圖還沒畫出來的時候就規劃路線一樣荒謬。

AI 開發更像科學研究:

舉個例子:你想做一個「減少模型幻覺」的功能。在傳統開發中,這可能是個明確的工單。但在 AI 開發中,這是個開放性研究問題,你甚至不知道是否能完全解決。

閱讀全文〈如何管理 AI 專案? AI PM 從確定性工程到應用研究〉

Hello! 各位 AI 開發者大家好 👋

我是 ihower,不知不覺這是第 30 期啦,感謝你一路以來的訂閱與支持 🙏

如果喜歡輕鬆交流和分享最新消息,歡迎加入 Telegram 討論群!

Hamel Husain 分享了真正成功的 AI 團隊的六個評估迭代策略:

先建評估基礎設施,再考慮具體功能。聽起來很慢,實際上是最快的路。

Hamel Husain 和 Shreya Shankar 整理了他們 AI Evals 課程 的 FAQ,收集了教 700+ 工程師和 PM 後最常被問的問題。包括:

上兩篇都重點提到錯誤分析,我整理了一篇文章來講什麼是 AI 應用評估的錯誤分析。文長請直接看我 blog 文章。

針對沒有標準答案的問答評估(對比有標準答案的是指單選、多選等有固定答案),這裏不同於常見的 G-Eval 評估方式採用正面表列,根據你的 Criteria 做評估量測打分(例如1~5分有多符合)。

這裏教的方法是先做錯誤分析,拿到具體的負面表列後,後續再針對 “每一種” 失敗模式都來做評估量測和改進。

最近在上 Hamel + Shreya 的 AI Evals For Engineers & PMs 課程,這應該是市面上最深入探討 AI 應用評估的課程了。以下根據網上有公開的內容,整理一篇精華內容(大約是課程的前1/4內容)。

如果你正在開發 AI 應用,應該都遇過這種情況:產品做出來了,看起來還行,但總覺得哪裡怪怪的。使用者抱怨一些奇怪的問題,但你不知道從何改起。這篇文章要介紹的就是評估和錯誤分析 Error Analysis 系統性方法。

閱讀全文〈什麼是 AI 應用評估的錯誤分析 Error Analysis?〉