Hello! 各位 AI 開發者大家好 👋

我是 ihower,這一期電子報的內容依然非常豐富,好內容太多可以寫。我的分享大多會首發在 Facebook 上,如果不怕吵想第一時間收到通知,可以加入我的 Facebook 廣播頻道。

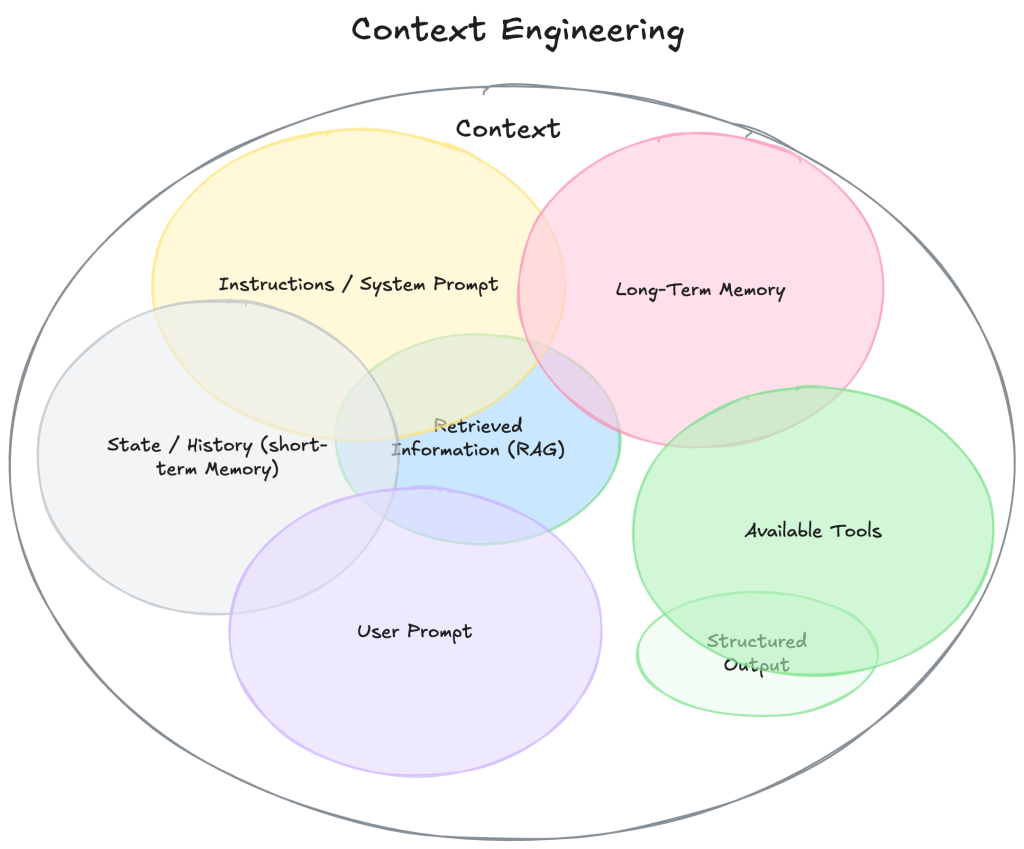

🔍 什麼是 Context Engineering 上下文工程?

Context Engineering 這個詞最近在 AI 技術圈被提出,能更廣泛統稱所有 Context 的動態管理。這篇文長有很多引用出處,請至我的 Blog 看全文。

更多討論在我 Facebook 貼文。

🧑🚀 大神 Andrej Karpathy 的最新演講 Software Is Changing 影片

大神 Andrej Karpathy 的最新演講 Software Is Changing (Again)

- 軟體正在經歷 70 年來最根本的變化: 軟體進化三階段

- LLM = 新作業系統

- 允許可以部分自主的 Agent 應用

- 軟體設計要服務三種用戶: 人類(GUI)+ 程式(API)+ AI Agent(新介面)

- 這是軟體史的關鍵轉折點

除了看影片,也可以看我的逐字稿截圖整理,這個網頁的用法是: 1. 直接用沈浸式網頁翻譯 2. 或是右上角我有做 Copy Transcript 可以複製回去,給你的 AI 用你喜歡的方式整理出你想要的內容,例如這我用 Claude 整理後變成的文章。

更多討論在我 Facebook 貼文。

閱讀全文〈愛好 AI Engineer 電子報 🚀 新技能組合 Context Engineering 上下文工程 #29〉