Hello! 各位 AI 開發者大家好 👋

跟大家拜個晚年!過年假期在玩 OpenClaw 非常有趣。

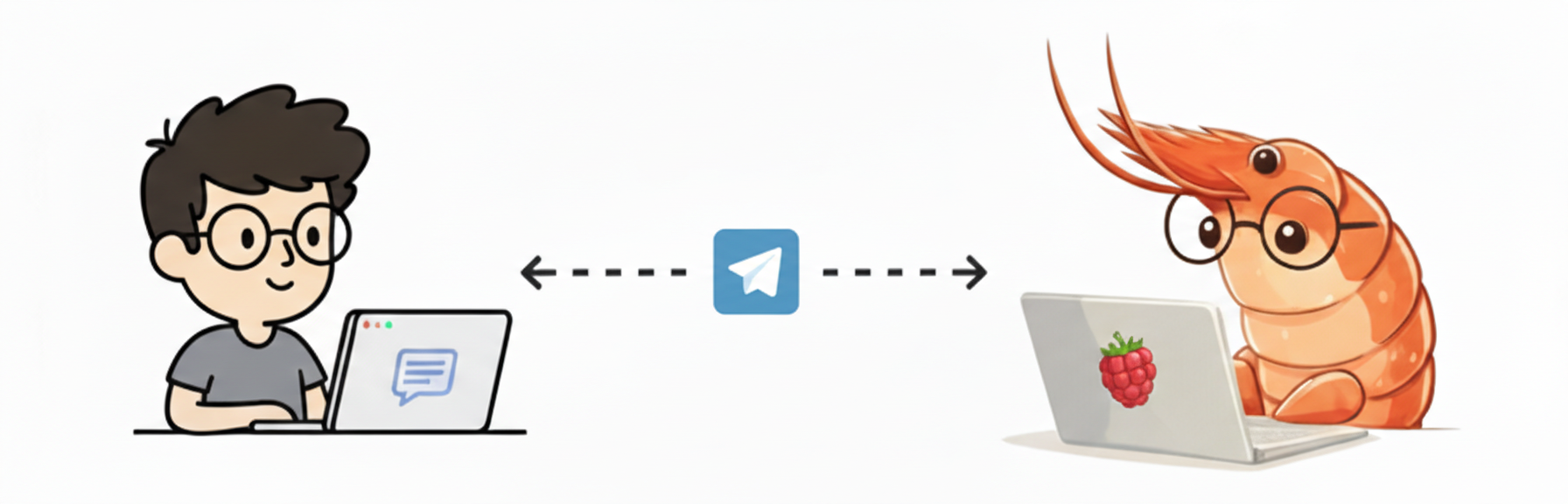

它是一個開源的自架 AI Agent 軟體,常駐在你的伺服器上。你會透過 Telegram、Discord 等通訊渠道,隨時隨地交代任務。等於擁有一個可以操作整台電腦、定時執行任務的個人助理。

我在 Facebook 上有分享了一些經驗,也有了一些新的想法:

目前玩法是把 OpenClaw 的 AI Agent (就叫蝦蝦吧)當作我的新員工看待,盡量只用 Telegram 交代他做事 (雖然偶爾還是會有出戲感,會需要手動SSH進去Server排除技術問題)

帳號也都是開新的給他,只開他任務需要知道的權限,而不是讓他去接手我的帳號權限。我認為這是比較好的安全界線。

這是我給蝦蝦新建立的帳號:

- 愛好 AI 工程 Blog: blog.aihao.tw/ (整個站都是AI生成)

- Threads: www.threads.com/@xia_aihao

- Facebook 粉專: www.facebook.com/xia.aihao

從本期電子報起,分享的文章摘要內容,會更直接就是 AI 生成的,會明確區分哪些內容完全是 AI 產出的。

相比之前電子報有花時間每篇人工審稿修改,之後會更放手直接就放 AI 產出,反正大家也看習慣 AI 摘要了(?)

不過放心,選題還是我真人做: 選擇哪些東西值得寫值得分享,還是有人類的聯想、判斷力和直覺。因此要分享哪些文章主題,都是我是挑好才交給 AI 後續處理的。

對於 AI 生成內容的閱讀建議: 只是幫助你快速掌握原文重點的導讀。畢竟原文往往篇幅較長、不容易快速消化,透過翻譯與摘要,

你可以在短時間內了解核心概念。但請留意,摘要無法涵蓋所有細節與脈絡。如果讀完覺得有興趣,強烈推薦點進原文獲得完整資訊。

換句話說: 時間充裕的話,可以直接點原文閱讀。如果時間有限,可以先看中文導讀,有興趣再深入原文。

無論如何,我對自己挑選要分享的原文還是有信心都是很好的內容 😄

在本期分享的精彩文章中,有幾篇我特別有收穫:

- 為什麼多數 Agent 框架都沒有內化 Bitter Lesson? 這篇把 Agent 框架的發展方向,搭配我很喜歡的 Bitter Lesson 一起講得非常到位,我很認同

- AI Agent 怎麼管理 Context? 從設計模式到 Deep Agents 實作 和 如何選擇 Multi-Agent 架構? LangChain 整理的 Agent 設計模式與架構選擇,很有系統性

- Agent Skills 完整攻略: 從建立到評估 Skill 的評估很少人講,「Skill 到底有沒有被順利觸發」是個關鍵問題

- AI Evals 閃卡全解析: Hamel Husain 的 12 張精華卡片 Hamel Husain 是我的 AI Eval 老師,他出的這套閃卡把核心方法論濃縮得非常精煉

⬇️⬇️ 以下是我挑選文章後,由 AI 生成的內容 ⚠️⚠️

閱讀全文〈愛好 AI Engineer 電子報 🚀 新型態代理人 OpenClaw 正夯,電子報改版 #35〉