Hello! 各位 AI 開發者大家好 👋

我是 ihower,這集是 AI Agents 代理人特輯,以下是我的推薦內容。

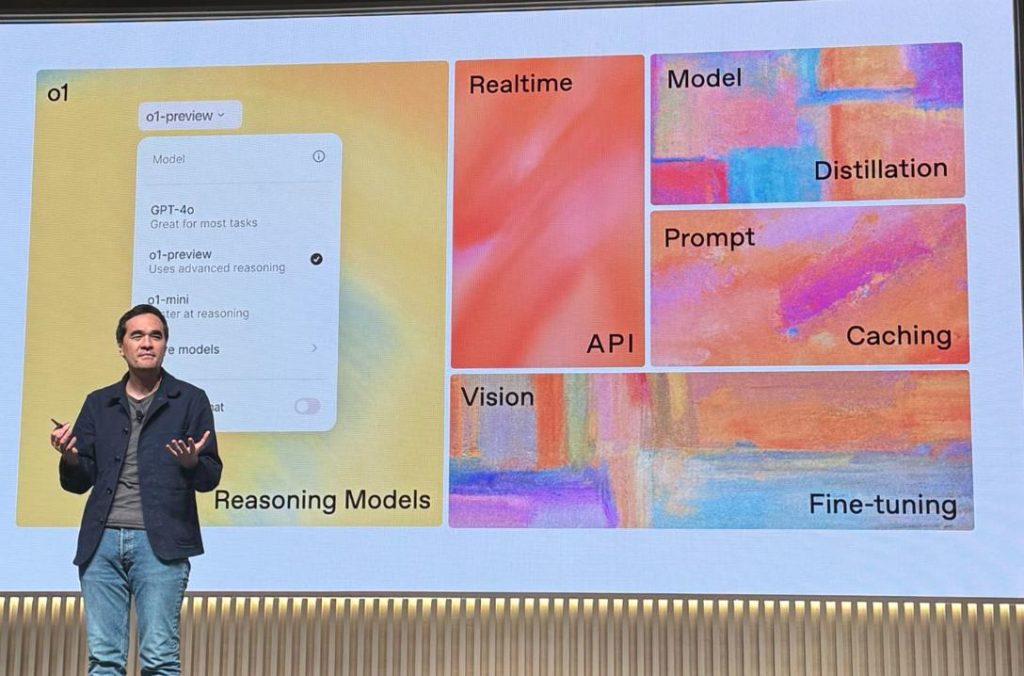

🔝 淺談 LLM-based AI Agents 應用開發 投影片

這是我在 WebConf Taiwan 2024 分享的演講投影片 PDF(14mb)。雖是淺談但自認誠意滿滿,相信只看投影片也能有不少收穫。

以下是議程介紹:

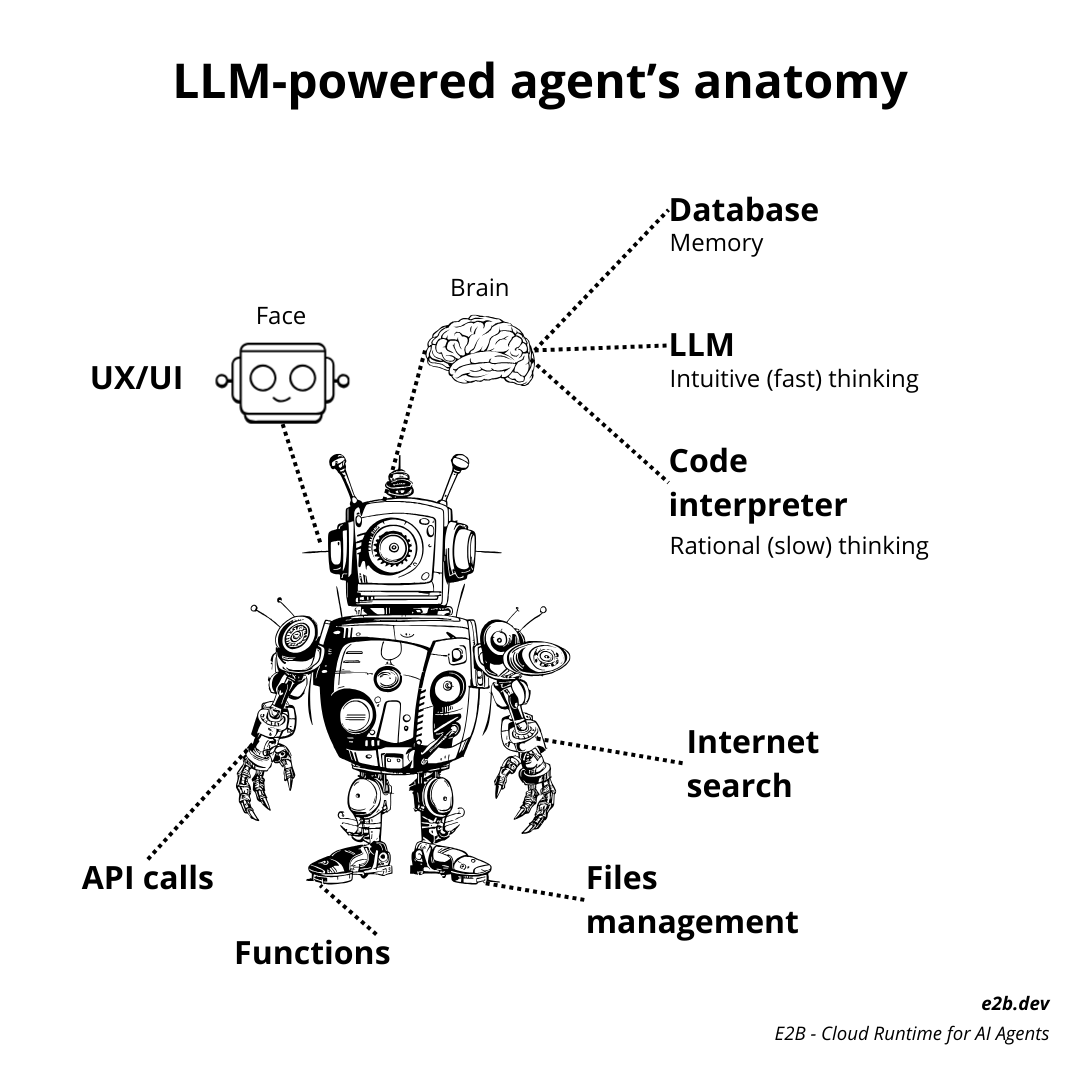

AI Agent!Multi-Agents!Agentic Workflow! 這些充斥業界的 buzzword 被吹捧得如夢似幻,這場演講將深入淺出探討這項技術,用樸實的技術實作說明其核心原理,揭示其真實的運作、能力範疇與侷限。希望能讓您遇到這些 buzzword 時,不再只是被表面所迷惑,而是能夠看穿其技術本質,洞悉浮華背後的真相。

👍 Building effective agents

由 Anthropic 闡述了關於 Agents 和 Workflow 架構的邏輯,以及常見的設計模式。非常值得一讀。在我投影片中也有引用並補充案例。

開發 LLM 應用的目標並不是要建立最複雜的系統,而是根據需求建立合適的系統。從簡單的提示開始,通過評估最佳化。當需要更多複雜性時,Workflow 提供可控性和一致性。當需要更靈活的模型驅動決策時,代理人 Agent 上場。

閱讀全文〈愛好 AI Engineer 電子報 🚀 代理人 AI Agents 特輯 #21〉